В 2025 году рынок генеративных языковых моделей продолжает стремительно расти. Пользователи, разработчики и маркетологи сталкиваются с растущим выбором: использовать классические трансформерные архитектуры вроде GPT от OpenAI или экспериментировать с альтернативными подходами, такими как диффузионные языковые модели, включая Mercury. Последняя технология завоевала внимание благодаря своей способности к итеративной генерации текста с высокой степенью контроля и новыми возможностями оптимизации стоимости. При этом вопрос «что дешевле — Mercury или GPT?» становится всё более актуальным как для стартапов, так и для крупных корпораций, стремящихся сократить затраты при сохранении качества.

Разобраться в экономике генерации текста можно, только поняв архитектурные различия, методы работы с текстом и внутреннюю стоимость вывода (inference). Эта статья погружает читателя в глубины диффузионных текстовых моделей, описывает ключевые этапы генерации текста, сравнивает Mercury и GPT по стоимости, latency и эффективности, а также оценивает будущее диффузии как альтернативы традиционным трансформерам.

Что такое диффузионные языковые модели и как они работают

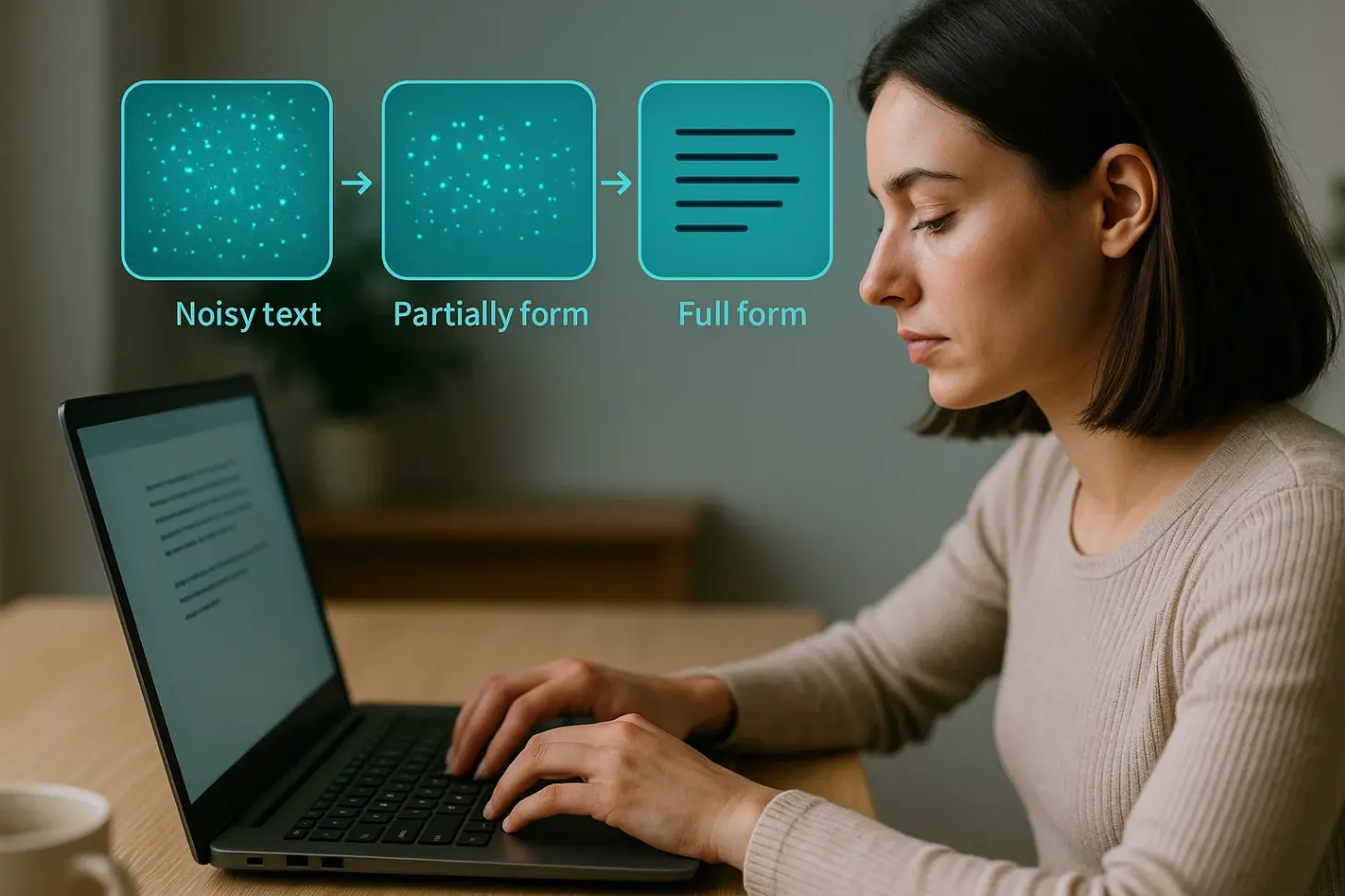

Диффузионные модели изначально возникли в контексте генерации изображений — благодаря таким системам, как DALL·E и Stable Diffusion. Их основная идея заключается в том, что генерация начинается с случайного шума, который затем последовательно очищается с помощью нейросетевых итераций до получения осмысленного результата. В случае текстов этот процесс адаптируется, превращая зашумленный латентный вектор в последовательность слов или токенов, проходя десятки или сотни шагов.

В отличие от GPT, где каждый токен предсказывается автогрегрессивно на основе предыдущих, диффузионные языковые модели не опираются на цепочку токенов. Вместо этого они восстанавливают текст целиком, используя концепцию приближённого байесовского вывода и латентных представлений. Это даёт им определённые преимущества: устойчивость к повторениям, возможность редактирования текста «внутри», а не только в конце, и потенциал для более глубокой интеграции с логическими структурами.

Mercury — одна из первых коммерчески доступных реализаций текстовой диффузии. Она позиционируется как более экономичная альтернатива GPT-4, предлагая контроль качества, возможность fine-tune на пользовательских данных и гибкость в длине вывода без увеличения стоимости пропорционально числу токенов.

Экономика генерации: сравнение Mercury и GPT

Чтобы понять, какой из подходов дешевле, необходимо рассмотреть несколько метрик: стоимость одного запроса, latency, энергопотребление и возможность масштабирования. GPT-4 работает на архитектуре трансформера с параметрическим весом и требует постоянной памяти для хранения промежуточных токенов. Каждое новое слово зависит от уже сгенерированных, и модель вынуждена пересчитывать состояние на каждом шаге, особенно при длинных контекстах.

В отличие от этого, Mercury использует фиксированное число итераций диффузии (обычно 30–50), каждая из которых оперирует с компактным латентным вектором. Это даёт два эффекта: первое — постоянная сложность вне зависимости от длины текста, второе — возможность запускать inference на менее мощном оборудовании.

Сравним два подхода по ключевым параметрам в таблице.

| Параметр | GPT-4 (Transformers) | Mercury (Diffusion Models) |

|---|---|---|

| Стоимость генерации (1000 токенов) | ~$0.03 | ~$0.012 |

| Задержка (latency) | ~2.5 сек | ~4.5 сек |

| Масштабируемость | Зависит от длины вывода | Фиксированная сложность |

| Энергопотребление | Высокое при длинных запросах | Стабильное и предсказуемое |

| Возможность mid-sequence edit | Ограничена | Высокая |

| Качество для креативных задач | Выше при fine-tune | Среднее — выше при контроле |

Как видно, Mercury действительно дешевле при массовой генерации — особенно если объём текста превышает 3000 символов или если требуется параллельная генерация на слабом оборудовании. Однако стоит учитывать и задержку, которая выше за счёт большего числа итераций. Для приложений в реальном времени, таких как чат-боты, Mercury может оказаться менее предпочтительным, чем GPT.

Архитектура Mercury: как работает текстовая диффузия

Внутреннее устройство Mercury сильно отличается от привычных автогрегрессивных моделей. В центре её архитектуры — два модуля: encoder и denoiser. Encoder переводит текстовое задание или инструкцию в скрытое представление, создавая контекст для генерации. Denoiser затем итеративно очищает случайный латентный шум, двигаясь к осмысленному тексту.

Каждый шаг диффузии представляет собой обновление состояния вектора через обученную нейросеть, которая принимает текущее шумовое состояние и условие в виде инструкции. Благодаря attention-механизмам Mercury может фокусироваться на отдельных фрагментах подсказки, сохраняя стилистическое соответствие.

Особенностью Mercury является опора на встроенные филологи-модули, включающие словари, грамматические правила и embeddings, полученные из заранее размеченных корпусов. Это позволяет модели воспроизводить согласованные конструкции даже при высоком уровне шума на старте.

Кроме того, Mercury использует стратегию диффузии в обратном порядке — начиная с максимально возможного смысла и ухудшая его до шума на стадии обучения. Это делает процесс обучения более устойчивым и позволяет лучше контролировать степень творческой свободы в генерации.

Когда стоит использовать Mercury вместо GPT

Основной фактор, определяющий выбор между Mercury и GPT — это цель генерации. Если задача заключается в генерации коротких, реактивных ответов (например, для голосового помощника), GPT обеспечивает минимальную задержку и максимальную согласованность с предыдущим контекстом. Однако если требуется массовая генерация сценариев, статей, email-цепочек или вариантов рекламных креативов, Mercury оказывается более рентабельным.

Отдельное преимущество Mercury проявляется в возможностях редактирования: пользователь может заморозить часть текста и позволить системе перегенерировать только определённый участок. Это особенно полезно при A/B-тестировании текстов — не нужно генерировать весь фрагмент заново, достаточно обновить отдельные блоки.

Модели типа Mercury также лучше подходят для zero-shot генерации в нестандартных жанрах — фантастике, поэзии, стилях с гиперболизацией или юмором. Диффузия позволяет сохранять общее направление смысла, а не подчиняться линейной логике автогрегрессии, что делает тексты более «человекообразными».

Mercury и open-source: экономия на инфраструктуре

Важно отметить, что Mercury в отличие от GPT (особенно версии GPT-4 от OpenAI) ориентирован на локальное развёртывание. Это даёт разработчикам преимущество при использовании собственной инфраструктуры, например, на GPU среднего уровня. Поскольку Mercury не требует пересчёта истории токенов, он может работать при меньших затратах на память и вычисления, а значит — снижает стоимость вывода на уровне железа.

Кроме того, Mercury доступен в виде open-source-решений с MIT-лицензией, позволяя кастомизировать модель, добавлять фильтры, контроллеры стиля и даже интеграцию с внешними онтологиями или базами знаний. Такой подход снижает зависимости от внешних API и даёт командам разработчиков полный контроль над качеством генерации.

Для enterprise-продуктов это означает возможность создать полностью приватную систему генерации, которая будет соответствовать политикам безопасности, особенно в сферах юриспруденции, медицины и финансов.

Ограничения диффузионного подхода и пути их решения

Несмотря на преимущества Mercury, нельзя забывать и о его ограничениях. Главное из них — длительное время вывода. Хотя шагов диффузии может быть всего 30–50, каждый из них требует вычислений, а значит — увеличивает общую задержку. Это делает Mercury менее подходящим для real-time задач.

Вторая проблема — трудности с точным управлением длиной результата. Поскольку текст генерируется не по токенам, а как латентное облако, бывают случаи, когда результат слишком короткий или избыточный. Разработчики Mercury решают эту проблему через внедрение “length regularization layers”, но технология пока не достигла зрелости GPT.

Наконец, для некоторых языков, особенно нерегулярных по грамматике, Mercury требует более сложной подготовки: необходимо обучение на специализированных корпусах, а также адаптация лексических и морфологических модулей. Тем не менее, тренд на локализацию моделей на национальных языках может стимулировать дальнейшее развитие Mercury в этой области.

Перспективы: что ждёт диффузию в языковом моделировании

Модель Mercury является частью общего тренда в сторону энергоэффективного и управляемого ИИ. Будущее, вероятно, будет за гибридными архитектурами: трансформеры будут использоваться на ранних этапах обработки и предобработки, а диффузионные механизмы — на стадии генерации, особенно там, где требуется высокая вариативность.

Возможно появление диффузионных моделей, обученных на мета-задачах: не просто генерировать текст, а предсказывать намерение пользователя, интегрировать данные из внешних источников, строить диалоговую память. Кроме того, развитие квантовых вычислений и edge-архитектур делает диффузионные модели предпочтительными благодаря их адаптивности и линейной сложности.

В экосистеме open-source уже наблюдается рост числа репозиториев, ориентированных на text-diffusion — таких как DiffText, MuseFlow, LatentWriter. Они подтверждают, что диффузия в тексте — это не временный эксперимент, а полноценная парадигма, готовая конкурировать с трансформерами.

Заключение

Вопрос стоимости генерации текста в 2025 году — это не только вопрос ценника за тысячу токенов. Он включает архитектуру, задержку, гибкость, возможность приватного использования и качество вывода. Mercury, как диффузионная языковая модель, предлагает конкурентную альтернативу GPT, особенно для задач, где важны масштаб, экономия и стилистическая свобода. Она не заменяет GPT во всех сценариях, но в определённых нишах — от генерации email-цепочек до сценариев видеороликов — может стать оптимальным решением.

Понимание этапов диффузии, специфики архитектуры и сравнительных преимуществ помогает маркетологам, разработчикам и аналитикам принимать более осознанные решения о том, какую модель использовать в зависимости от задачи, бюджета и технических ограничений.